논문 링크: 2201.09865

저자: Andreas Lugmayr, Martin Danelljan, Andres Romero, Fisher Yu, Radu Timofte, Luc Van Gool

소속: Computer Vision Lab, ETH Z¨ urich, Switzerland

발행일: 2022 8월 31일

1. Abstract

- Free-form Inpainting은 이미지에서 임의의 바이너리 마스크로 지정된 영역에 새로운 콘텐츠를 추가하는 작업이다.

- 기존 방법들은 특정 마스크 분포에 대해 훈련되며, 이로 인해 보지 못한 새로운 마스크 유형에 대한 일반화 성능이 제한된다.

- 또한, 픽셀 단위 및 perceptual loss 기반의 훈련 방식은 종종 단순한 텍스처 확장에만 집중하며, 의미론적으로 자연스러운 생성이 어렵다.

- 본 논문에서는 RePaint를 제안한다:

- Denoising Diffusion Probabilistic Model (DDPM) 기반의 inpainting 접근법

- 극단적인 마스크에서도 적용 가능

- 사전 학습된 unconditional DDPM을 생성 prior로 활용

- 생성 과정에서 reverse diffusion을 수행할 때만 마스크가 적용되지 않은 영역을 원본 이미지 정보로 샘플링

- 기존 DDPM 네트워크를 수정하거나 새로운 훈련 없이 높은 품질과 다양한 결과물을 생성할 수 있음

- 얼굴 및 일반적인 inpainting 작업을 위해 CelebA-HQ 및 ImageNet 데이터셋을 활용하여 검증하였으며, 다양한 마스크 분포에서 SOTA (State-of-the-Art) Autoregressive 및 GAN 기반 방법을 능가하는 성능을 보임.

- Github Repository: git.io/RePaint

2. Introduction

- 이미지 Inpainting (Image Completion)은 이미지에서 손실된 영역을 채우는 작업으로, 해당 부분이 원본 이미지와 조화를 이루면서도 의미론적으로 자연스러워야 한다.

- 기존의 SOTA 기법들은 주로 GAN (Generative Adversarial Networks) 또는 Autoregressive 모델에 의존함.

- Inpainting 작업에서는 다음과 같은 다양한 마스크 유형을 처리해야 한다:

- 얇거나 두꺼운 붓으로 그린 마스크

- 정사각형 마스크

- 심지어는 이미지 대부분이 손실된 극단적인 마스크

- 기존 방법들은 특정 마스크 분포에서 훈련되기 때문에 새로운 유형의 마스크에 대한 일반화가 어렵다.

- 대안적인 생성 모델 접근법 탐색 필요:

- 마스크별 훈련 없이 작동하는 inpainting 기법이 필요함.

DDPM (Denoising Diffusion Probabilistic Models)

- DDPM은 최근 등장한 새로운 생성 모델 패러다임으로, 확률적 샘플링을 통해 점진적으로 이미지를 생성하는 방법이다.

- 최근 연구에서는 DDPM이 기존 SOTA GAN 기반 모델보다 더 나은 성능을 보일 수 있음을 입증함.

- DDPM의 기본 원리는 다음과 같다:

- Forward Process: 원본 이미지를 점진적으로 노이즈 추가하여 무작위 가우시안 분포로 변환

- Reverse Process: 노이즈에서 점진적으로 원본 이미지를 복원

- 결과적으로 높은 품질과 다양한 샘플 생성 가능

RePaint 기법

- 기존 방법의 한계:

- 기존 DDPM 방식은 단순한 텍스처 매칭만 수행하며, 의미론적 오류가 발생할 가능성이 있음.

- RePaint의 주요 아이디어:

- unconditional DDPM 활용: 특정 마스크에 대해 추가 훈련이 필요 없음.

- Reverse Diffusion 과정에서 원본 픽셀을 이용한 샘플링 적용:

- 원본 픽셀이 남아있는 부분은 그대로 유지

- 결측 영역만 DDPM을 통해 복원

- Resampling 기법 도입:

- 단순한 역확산이 아니라 일정 부분 forward diffusion을 수행한 후 다시 역확산을 반복하는 방식

- 보다 자연스럽고 의미론적으로 타당한 복원 가능

- RePaint의 장점:

- 모든 마스크 유형에 일반화 가능

- 의미론적 일관성 유지

- 강력한 DDPM 기반 이미지 생성 prior 활용

- CelebA-HQ 및 ImageNet 데이터셋을 활용한 실험을 통해 기존 방법 대비 더 의미론적으로 자연스러운 복원 성능을 입증.

3. Related Work

3.1 Deterministic Image Inpainting

- GAN 기반 방법:

- 최초의 Encoder-Decoder 기반 inpainting 기법

- 주요 기법:

- Dilated Convolutions: receptive field 증가

- Partial & Gated Convolutions: 마스크 적용을 고려한 합성곱 연산

- Contextual Attention: 전역적인 컨텍스트 활용

- Edge & Semantic Segmentation Maps: 의미론적 구조 활용

- GAN은 텍스처 생성에는 강하지만 의미론적 일관성이 부족함.

3.2 Diverse Image Inpainting

- 기존 GAN 기반 방법은 결정론적 성향이 강하여 다양한 복원이 어려움.

- 해결책:

- VAE 기반 접근법: 다양성 vs. 재구성 성능(trade-off)

- Autoregressive 모델: 불규칙한 마스크에 대응 가능하지만 연산량이 큼.

3.3 Image Prior 활용

- StyleGAN 기반 inpainting 연구들이 있었으나, 특정 얼굴 데이터에 한정됨.

- RePaint는 DDPM을 Prior로 활용하여 일반적인 이미지 복원이 가능.

3.4 Conditional Diffusion Models

- 기존 연구들은 정량적 비교 부족, 제한된 마스크 대응.

- ILVR(DDPM 기반 guided generation)은 저주파 정보만 활용하여 inpainting에는 적합하지 않음.

- RePaint의 차별점:

- Fully Unconditional DDPM을 사용

- Reverse Diffusion 과정에서만 Conditioning 수행

- 특정 마스크 없이 자유로운 Free-Form Inpainting 가능

4. Preliminaries: Denoising Diffusion Probabilistic Models (DDPM)

본 논문에서는 Diffusion 모델을 생성 모델로 사용한다.

Diffusion 모델은 다른 생성 모델과 마찬가지로, 주어진 학습 데이터셋을 기반으로 이미지 분포를 학습하는 방식이다.

DDPM의 추론 과정은 무작위 노이즈 벡터 $x_T$를 샘플링한 후, 점진적으로 노이즈를 제거하여 고품질의 출력 이미지 $x_0$를 생성하는 방식으로 이루어진다.

훈련 과정에서, DDPM은 Diffusion 과정을 정의하여 원본 이미지 $x_0$를 $T$개의 시간 단계에 걸쳐 점진적으로 백색 가우시안 노이즈 $x_T \sim \mathcal{N}(0, I)$로 변환한다.

4.1 Forward Process

Forward Process에서는 각 시간 단계 $t$에서 원본 이미지 $x_0$에 점진적으로 노이즈를 추가하며, 이 과정은 다음과 같은 확률 분포로 정의된다:

$$q(x_t | x_{t-1}) = \mathcal{N}(x_t; \sqrt{1 - \beta_t} x_{t-1}, \beta_t I)$$

여기서:

- $\beta_t$는 시간 단계 $t$에서 적용되는 노이즈 분산 (variance)으로, 보통 작은 값에서 시작해 점진적으로 증가한다.

- $x_t$는 이전 시간 단계의 이미지 $x_{t-1}$에 가우시안 노이즈를 추가하여 생성되며, 다음과 같이 계산된다:

$$x_t = \sqrt{1 - \beta_t} x_{t-1} + \epsilon, \quad \epsilon \sim \mathcal{N}(0, \beta_t I)$$

즉, $x_t$는 이전 이미지 $x_{t-1}$를 $\sqrt{1 - \beta_t}$만큼 스케일링한 후, 평균이 0이고 분산이 $\beta_t$인 가우시안 노이즈를 추가하여 샘플링된다.

4.2 Reverse Process

DDPM의 핵심 목표는 Forward Process를 거친 노이즈화된 이미지 $x_T$에서 점진적으로 노이즈를 제거하여 원본 이미지를 복원하는 것이다.

이 과정은 Reverse Diffusion 과정으로 모델링되며, 다음과 같은 확률 분포를 따른다:

$$p_\theta(x_{t-1} | x_t) = \mathcal{N}(x_{t-1}; \mu_\theta(x_t, t), \Sigma_\theta(x_t, t))$$

여기서:

- $\mu_\theta(x_t, t)$와 $\Sigma_\theta(x_t, t)$는 뉴럴 네트워크 $p_\theta$가 예측하는 가우시안 분포의 평균과 분산이다.

- 즉, 모델은 $x_t$를 입력으로 받아, 그보다 한 단계 이전인 $x_{t-1}$의 분포를 추정하여 샘플링한다.

4.3 Training Objective

DDPM은 변분 하한 (Variational Lower Bound, VLB)을 최적화하는 방식으로 학습된다.

즉, 원본 이미지 $x_0$를 최대한 정확하게 복원하는 방향으로 학습을 진행한다.

변분 하한은 다음과 같이 정의된다:

$$E[-\log p_\theta(x_0)] \leq E_q \left[ -\log p_\theta(x_{0:T}) + \sum_{t \geq 1} \log \frac{p_\theta(x_{t-1} | x_t)}{q(x_t | x_{t-1})} \right]$$

이를 통해 모델이 Forward Process에서 발생한 정보 손실을 최소화하면서 원본 이미지 $x_0$를 정확히 재구성할 수 있도록 학습이 진행된다.

4.4 Loss Function

Ho et al.는 위의 변분 하한을 보다 단순화하여 보다 효과적인 손실 함수를 도출하였다.

특히, 각 시간 단계에서 예측된 노이즈와 실제 노이즈 간의 차이를 최소화하는 방식이 가장 효과적이라는 점을 발견하였다.

이에 따라, DDPM의 최종 손실 함수는 다음과 같이 정의된다:

$$\mathcal{L}_{simple} = E_{t, x_0, \epsilon} \left[ \|\epsilon - \epsilon_\theta(x_t, t)\|^2 \right]$$

즉, 신경망 $\theta$는 특정 시점 $t$에서 노이즈화된 이미지 $x_t$를 입력받아, 해당 시점의 원본 이미지에 추가된 노이즈 $\epsilon$을 예측하도록 학습된다.

4.5 예측 평균 $\mu_\theta(x_t, t)$의 매개변수화

Ho et al.는 역확산 과정에서 가우시안 분포의 평균 $\mu_\theta(x_t, t)$를 직접 예측하기보다는, 누적된 노이즈 $\epsilon_0$를 예측하는 방식이 더 효과적임을 발견하였다.

이때, $\mu_\theta(x_t, t)$는 다음과 같이 표현된다:

$$\mu_\theta(x_t, t) = \frac{1}{\sqrt{\alpha_t}} \left( x_t - \frac{\beta_t}{\sqrt{1 - \bar{\alpha}_t}} \epsilon_\theta(x_t, t) \right)$$

여기서:

- $\bar{\alpha}_t$는 시간 $t$까지의 누적 노이즈 감소율을 의미하며, 다음과 같이 정의된다:

$$\bar{\alpha}_t = \prod_{s=1}^{t} (1 - \beta_s)$$

이 수식을 통해, DDPM 모델이 $x_t$를 입력으로 받아 원본 이미지에 추가된 노이즈 $\epsilon$을 예측하고, 이를 이용해 역확산을 수행할 수 있다.

4.6 샘플링 과정에서의 효율적인 변환

Forward Process에서 특정 시점 $x_t$를 직접 샘플링하는 수식은 다음과 같이 정리된다:

$$q(x_t | x_0) = \mathcal{N}(x_t; \sqrt{\bar{\alpha}_t} x_0, (1 - \bar{\alpha}_t) I)$$

이를 통해 DDPM은 특정 시점 $t$에서 Forward Process의 전체 과정을 한 번의 샘플링으로 진행할 수 있다.

이를 활용하면, 학습 및 추론 과정에서 보다 효율적인 데이터 샘플링이 가능하다.

4.7 샘플링 속도 개선을 위한 기법

DDPM의 샘플링 과정은 본질적으로 여러 단계의 역확산 과정을 포함하므로, 계산량이 많고 속도가 느리다.

이를 개선하기 위해, Nichol & Dhariwal은 분산 $\Sigma_\theta(x_t, t)$ 학습을 도입하여 샘플링 속도를 크게 향상시켰다.

본 논문에서는 Dhariwal & Nichol의 접근법을 기반으로 학습 및 추론을 수행하여, 기존 DDPM보다 약 4배 빠른 샘플링 속도를 달성하였다.

5. Method

- 먼저, 비조건부 DDPM(Unconditional DDPM)의 역확산 과정에서 특정 영역을 조건으로 적용하는 방법을 소개한다.

- 이후, 역확산 과정 자체를 개선하여 더 나은 성능을 달성하는 방법을 설명한다.

5.1. Conditioning on the Known Region

이미지 Inpainting의 목표는 주어진 마스크(mask) 영역을 조건으로 사용하여 누락된 픽셀을 예측하는 것이다.

본 논문에서는 사전 훈련된 비조건부 DDPM(Unconditional DDPM)을 사용하여 이 문제를 해결한다.

기호 정의:

- 원본 이미지 $x$

- 알려진(손실되지 않은) 픽셀: $(1 - m) \odot x$

- 알려지지 않은(손실된) 픽셀: $m \odot x$

- $\odot$: 요소별(element-wise) 곱셈 연산을 의미.

역확산 과정에서 알려진 영역 반영하기

기본적으로 DDPM의 역확산(reverse diffusion) 과정은 오직 현재 상태 $x_t$에만 의존한다.

따라서, 우리가 알려진 영역을 직접 변경하더라도 전체 확률 분포의 성질을 유지할 수 있다.

- Forward Process는 Markov Chain으로 가우시안 노이즈를 점진적으로 추가하는 방식으로 정의된다.

- 이 성질을 활용하면, 특정 시간 단계 $t$에서 $x_t$를 샘플링할 수 있다.

- 이를 활용하면 알려진 영역을 유지한 채 역확산 과정을 진행할 수 있다.

- 마스크 영역이 없는 픽셀은 원본 $x_0$을 기준으로 샘플링.

- 마스크 영역이 있는 픽셀은 기존의 DDPM 역확산 방식을 사용하여 샘플링.

이를 통해, 한 번의 역확산 단계에서 다음과 같은 샘플링 과정을 수행한다:

$$x_{t-1}^{\text{known}} \sim \mathcal{N}(\sqrt{\bar{\alpha}_t} x_0, (1 - \bar{\alpha}_t)I)$$ $$x_{t-1}^{\text{unknown}} \sim \mathcal{N}(\mu_\theta(x_t, t), \Sigma_\theta(x_t, t))$$ $$x_{t-1} = m \odot x_{t-1}^{\text{known}} + (1 - m) \odot x_{t-1}^{\text{unknown}}$$

즉:

- 알려진 영역 ($x_{t-1}^{\text{known}}$)은 원본 이미지 $x_0$을 기준으로 샘플링됨.

- 손실된 영역 ($x_{t-1}^{\text{unknown}}$)은 기존 DDPM 방식대로 샘플링됨.

- 이 두 개를 합쳐서 최종적으로 $x_{t-1}$을 얻음.

이 과정을 통해, 마스크가 적용된 영역만 DDPM을 통해 생성하며, 원본 이미지의 정보를 최대한 유지할 수 있다.

5.2. Resampling

기본적인 문제점

- 위의 방법만 적용하면, 생성된 영역이 알려진 영역의 texture와 일치하지만, 의미론적으로 부자연스러울 가능성이 높음.

- 그림 3의 $n = 1$ 예시에서 강아지의 털 패턴이 잘 맞지만, 생성된 이미지가 의미론적으로는 부자연스러움.

- 즉, DDPM은 알려진 영역과의 일관성을 맞추려 하지만, 전체적인 의미를 고려하는 것은 아님.

문제의 원인 분석

- 그림 2를 통해, 모델이 알려진 영역을 조건으로 사용하는 방식을 분석할 수 있다.

- 수식 (8)에 따르면, 모델은 $x_t$를 이용해 $x_{t-1}$을 예측한다.

- 하지만 이 과정에서 알려진 영역을 샘플링할 때, 생성된 부분과의 일관성을 고려하지 않음.

- 이로 인해, 역확산 과정에서 부조화(disharmony)가 발생하게 됨.

- 또한, 역확산 단계가 진행될수록 이미지의 변형이 점점 줄어들므로, 생성된 부분의 부조화를 수정하기 어려움.

해결책: Resampling을 이용한 보완

이 문제를 해결하기 위해 Resampling 기법을 도입한다.

- 기본적인 원리

- DDPM은 원본 이미지의 분포 내에서 일관성 있는 구조를 생성하려는 경향이 있음.

- 따라서, 한 번 생성된 이미지가 부자연스러울 경우, 다시 일부 과정을 거쳐 조화를 맞출 수 있음.

- Resampling 방법

- $x_{t-1}$을 샘플링한 후, 다시 Forward Diffusion을 한 단계 적용하여 $x_t$로 되돌림.

- 그런 다음, 다시 역확산 과정을 수행하여 $x_{t-1}$을 새롭게 샘플링.

- 이를 통해, 알려진 영역과 손실된 영역 간의 조화를 맞추면서 점진적으로 개선할 수 있음.

- Resampling 수식

- 기본적인 역확산 식은 다음과 같다:

$$x_t \sim \mathcal{N}(\sqrt{1 - \beta_t} x_{t-1}, \beta_t I)$$

- 즉, 한 번 생성된 $x_{t-1}$을 다시 Forward Process를 적용하여 $x_t$로 변환한 후, 다시 역확산을 진행한다.

5.3. Resampling의 효과

그림 3을 보면:

- $n = 1$ (기본 DDPM) → 생성된 부분과 원본의 조화가 부족함.

- $n = 2$ (한 번의 Resampling) → 더 나은 조화가 이루어짐.

- $n = 10$ 이후 → 더 이상의 개선 효과가 감소.

따라서, 적절한 Resampling 횟수를 설정하는 것이 중요하며, 본 논문에서는 $n = 10$이 가장 효과적이라고 판단함.

5.4. Resampling과 Slowing Down의 차이

- 기존 연구에서는 Slowing Down 기법을 사용하여 역확산 과정의 속도를 조절하는 방식이 제안되었음.

- 하지만, Slowing Down 방식은 이미지의 조화를 개선하는 데 한계가 있음.

- 본 논문의 Resampling 기법은 단순히 속도를 조절하는 것이 아니라, 이미지를 보다 의미론적으로 자연스럽게 조화시키는 것이 목표임.

5. Experiments

5.1. Implementation Details

방법을 CelebA-HQ 및 ImageNet 데이터셋에서 검증한다.

사전 훈련된 Guided Diffusion Model을 사용하며, 제공된 ImageNet 모델을 사용한다.

CelebA-HQ 데이터셋에서는 ImageNet과 동일한 학습 하이퍼파라미터를 적용한다.

- 이미지 크기: $256 \times 256$

- 배치 크기: 3개 배치(batch)

- GPU 사용: 4 × V100 GPU

- CelebA-HQ 학습 횟수: 약 250,000회 반복, 총 5일 소요

- 논문의 모든 정량적 및 정성적 결과는 256 × 256 크기의 이미지에서 실험.

최종 방법에서,

- Time Steps $T = 250$

- Resampling Steps $r = 10$

- Jump Size $j = 10$

으로 설정하였다.

5.2. 평가 지표 (Metrics)

우리는 RePaint 모델을 기존 기법들과 비교하기 위해 User Study 및 LPIPS를 활용한다.

(1) User Study

- 실험 참가자들은 마스킹된 입력 이미지를 본 후,

- 두 개의 인페인팅 결과 중 더 현실적인(realistic) 이미지를 선택하도록 요청받음.

- 참가자가 특정 기법을 선택할 때 랜덤하게 표시하여 편향을 방지함.

- 참가자는 동일한 질문에 대해 두 번 응답해야 하며, 75% 이상의 일관성을 보일 경우에만 응답이 유효함.

(2) LPIPS (Learned Perceptual Image Patch Similarity)

- CNN 기반의 지각적 유사도(Perceptual Similarity)를 측정하는 객관적 평가 지표.

- AlexNet의 딥러닝 feature 공간에서 이미지 간 차이를 계산함.

- 값 범위: 0 ~ 1 (낮을수록 원본과 유사)

- 우리는 동일한 100장의 테스트 이미지에서 LPIPS를 계산하여 비교함.

실험 환경

- CelebA-HQ 및 ImageNet 데이터셋의 100개 테스트 이미지 사용

- 마스크 유형: Wide, Narrow, Every Second Line, Half Image, Expand, Super-Resolve

- 각 비교에 대해 5명의 사람이 응답 → 1000개 이상의 투표 데이터 확보

- 결과 표현: 95% 신뢰 구간(Confidence Interval)과 평균 득표율 제시

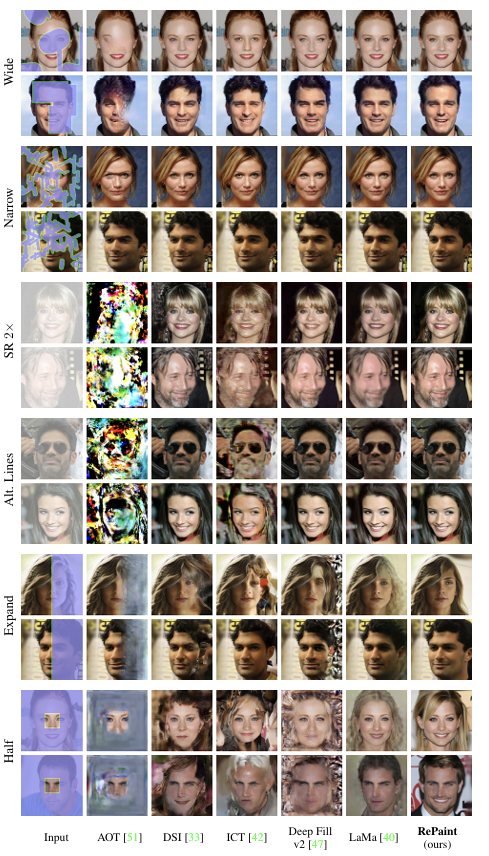

5.3. Comparison with State-of-the-Art

기존 Autoregressive 및 GAN 기반 기법들과 비교 실험을 진행한다.

- Autoregressive 기반 기법: DSI, ICT

- GAN 기반 기법: DeepFillv2, AOT, LaMa

- CelebA-HQ 실험: FFHQ 사전 훈련된 ICT 모델 사용

- ImageNet 실험: LaMa 모델을 직접 300,000회 반복 학습하여 실험 진행

실험 설정

- 256 × 256 크기의 이미지 사용

- CelebA-HQ 및 ImageNet 테스트 세트 활용

- 6가지 마스크 유형에 대한 정량적 평가 수행

결과 분석

- Wide & Narrow Mask: RePaint가 모든 방법보다 우수하며, 95% 유의 수준에서 통계적으로 유의미한 성능 향상을 보임.

- Thin Mask (Super-Resolution & Alternating Lines): RePaint가 73.1%~99.3%의 사용자 투표율을 기록하며, 기존 기법 대비 큰 성능 향상.

- Thick Mask (Expand & Half): RePaint가 더 높은 품질의 의미론적 보완(semantic completion)을 생성하나,

- 일부 경우에서는 LaMa가 LPIPS 점수에서 더 낮은 값(좋은 성능)을 보임.

- 하지만 LaMa는 Checkerboard artifacts가 존재하여 주관적인 사용자 평가에서 더 낮은 점수를 받음.

5.4. 다양성 분석 (Analysis of Diversity)

RePaint는 확률적(Stochastic) 모델로, 매번 새로운 인페인팅 결과를 생성 가능함.

- 기존 GAN 기반 방법은 하나의 고정된 결과를 출력하는 반면,

- DDPM 기반 RePaint는 다양한 가능성을 탐색할 수 있음.

5.5. 클래스 조건부 실험 (Class Conditional Experiment)

사전 훈련된 ImageNet DDPM 모델은 클래스 조건부 생성(class-conditional generation)이 가능하다.

- 확대 마스크(Expand Mask)를 적용하여 특정 클래스(예: Granny Smith 사과)를 생성하는 실험을 진행함.

- 결과: 마스킹된 부분을 주어진 클래스와 일치하는 이미지로 채움을 확인할 수 있음.

- 추가적으로 다양한 클래스(양배추, 브로콜리, 콜리플라워 등)에 대해 실험 진행.

5.6. Ablation Study

(1) Resampling과 Slow Diffusion의 비교

- Slow Diffusion: 기존 방법처럼 더 많은 타임 스텝을 사용하여 점진적으로 이미지 품질을 개선하는 방법

- Resampling: RePaint에서 제안한, 일부 단계를 되돌려 다시 생성하는 방법

- 결과: 동일한 계산량을 사용했을 때, RePaint의 Resampling이 더 나은 성능을 보임.

(2) Resampling의 Jump Length 실험

- $j = 1$일 때: 이미지가 흐릿하게 출력됨

- $j = 10$일 때: 가장 높은 품질의 인페인팅 결과 생성

- 최적의 설정: $j = 10$, $r = 10$

(3) 기존 SDEdit 방법과의 비교

- Super-Resolution 마스크 실험에서 RePaint가 SDEdit 대비 53% 성능 향상.

- 결과: RePaint의 Resampling 방식이 기존 SDEdit보다 우수한 성능을 보임.

6. Limitations

- 속도 문제

- DDPM 기반 방법은 GAN 기반 기법보다 훨씬 느림

- 현재 실시간(real-time) 응용에는 적합하지 않음

- 하지만 최신 연구에서는 DDPM의 연산 속도를 줄이기 위한 기법들이 개발 중임.

- 극단적 마스크(extreme mask)

- 마스크가 너무 크면, 생성된 이미지가 원본과 매우 다를 가능성이 있음

- 따라서 LPIPS 같은 지표로는 평가하기 어려움 → 대체로 FID(Frechet Inception Distance) 사용이 제안됨

7. Conclusions

우리는 DDPM 기반 인페인팅 방법인 RePaint를 제안했으며,

- 마스크 비종속(mask-agnostic) 접근법을 활용하여

- 최신 기법들보다 높은 품질의 인페인팅을 수행함을 보였다.

또한, 기존 GAN 및 Autoregressive 기법의 한계를 넘어서는 다양성을 제공함을 실험적으로 입증하였다.